前言

主要进行Qwen模型架构讲解。

1.Qwen整体介绍

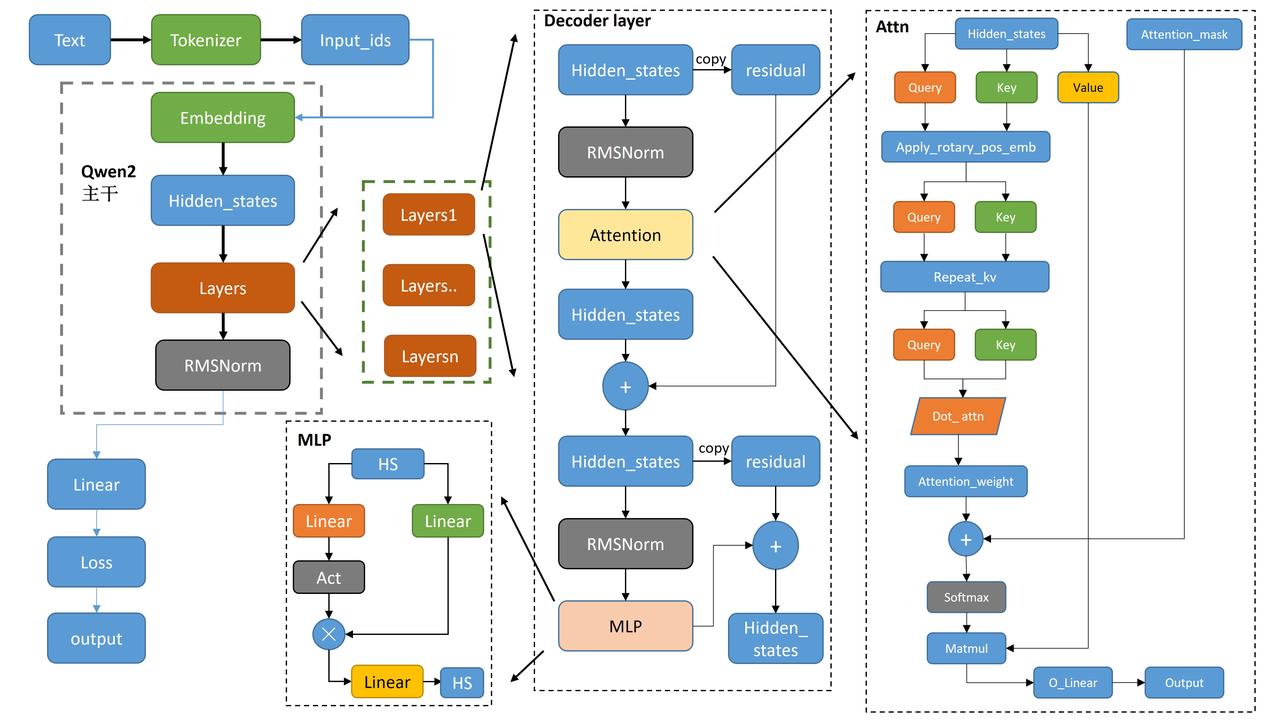

Qwen的整体架构与Llama2类似,如下图所示:

- tokenizer将文本转为词表里面的数值。

- 数值经过embedding得到一一对应的向量。

- attention_mask是用来看见左边、右边,双向等等来设定。

- 各类下游任务,Casual, seqcls等,基本都是基础模型model后面接对应的Linear层,还有损失函数不一样。

2.学习记录

在本次课程中,我深入学习了Transformer和Qwen2这两种先进的算法原理,并通过实践掌握了它们的代码实现流程。通过对相关源码的细致研读,我领悟到了Transformer中的位置编码(PE)与Qwen2中的相对位置编码(RoPE)之间的联系和它们各自独特的特点。这段学习经历极大地丰富了我的知识储备,并提升了我的技术理解力。

© 版权声明

本站所有资源来自于网络,仅供学习与参考,请勿用于商业用途,否则产生的一切后果将由您(转载者)自己承担!

如有侵犯您的版权,请及时联系3500663466#qq.com(#换@),我们将第一时间删除本站数据。

如有侵犯您的版权,请及时联系3500663466#qq.com(#换@),我们将第一时间删除本站数据。

THE END

暂无评论内容