1. 数据科学伦理的兴起

1.1. 数据科学实践包括:获取数据、(预)处理数据、分析数据、对数据进行建模、评估结果,然后使用模型或结果学习知识、支持论点或做决策

1.2. 数据科学家

-

1.2.1. 被誉为21世纪最具吸引力的职业

-

1.2.2. 不仅要在现有数据集上调用预先定义库,还要在数据科学项目里的每一步都做出重要抉择,从数据收集到模型调度,概莫能外

1.3. 积极方面

-

1.3.1. 在危机管理方面预测恐怖袭击

-

1.3.2. 检测税务诈欺

-

1.3.3. 在商业中增加盈利收入或降低成本

1.4. 负面影响

-

1.4.1. 隐私侵犯行为有增无减

-

1.4.2. 数据行业给敏感群体带来歧视

-

1.4.3. 无法解释数据行业做出的决策

1.5. 伦理事关是非对错

-

1.5.1. 合乎伦理规范虽然早已成为一个人生目标,但它同样也具有社会和商业意义

-

1.5.2. 数据科学伦理会导致严重的声誉和金融风险

- 1.5.2.1. 不合乎伦理的数据科学会给人们带来精神和身体伤害,而诉讼与和解也会导致严重的经济损失

1.6. 在涉及数据科学之际,各大部门、不同级别的管理人员需提出恰当的问题、解释、质疑结果,并在此基础上做出正确的决定

-

1.6.1. 即使拥有强大的数据科学能力、杰出的数据科学家和商业人士,科技巨头公司同样也会面临伦理问题

-

1.6.2. 数据科学家和管理人员并非天生缺乏职业道德,而是未曾受过相关培训

1.7. 注重数据科学伦理会带来实际效益

-

1.7.1. 伦理思维有益于数据和数据科学模型的改良,可能会给我们带来更精准的预测,或者用户更易接受的数据科学模型

-

1.7.2. 除了改良的数据科学模型,伦理实践也是一种成功的营销工具

- 1.7.2.1. 苹果公司越来越强调其产品的隐私性

-

1.7.3. 数据科学伦理可通过高收入、低成本、高利润来提高它的商业价值

1.8. 当今社会期望企业领导和数据科学家均能承担伦理责任

-

1.8.1. 数据主体、数据科学家和企业领导都很清楚数据科学的巨大作用

-

1.8.2. 在任意一家数据科学占据重要地位的企业中,数据科学伦理和企业社会责任占有同样的分量

1.9. 在数据科学实践中,数据科学伦理是用于指导人们分辨是非对错的准则

- 1.9.1. 合乎伦理的标准也随着时间、应用程度甚至地区等因素而不断变化

1.10. 每个企业和个人均需衡量伦理考量的重要性和数据实用程序的效用

- 1.10.1. 两者各自的权重有助于数据科学伦理达到平衡,从而进行正确的数据科学实践

2. 对错之分

2.1. 亚里士多德

-

2.1.1. 认为学习伦理学可以提高我们的生活质量。我们接受正统的教育、选择正义的行为、培养优良的习惯,这些都有利于我们形成良好、稳定的性格(与意识有关,与习惯不同)

-

2.1.2. 另一见解是伦理道德行为即在两个极端(过度和不足)行为之间的平均值

2.2. 伦理:决定一个人的行为或进行一项活动的道德规范

2.3. 道德:与个人行为对错有关的准则和规范

2.4. 法律告诉我们可以做什么,而伦理则告诉我们应该做什么

-

2.4.1. 伦理回答了是非对错的问题

-

2.4.2. 法律和伦理之间密不可分,伦理有时会上升到法律层面,而且法律思维和伦理思维会有所重叠

2.5. 通用数据保护条例

-

2.5.1. 欧洲联盟(欧盟)

-

2.5.2. General Data Protection Regulations, GDPR

-

2.5.3. 涵盖了许多与隐私相关的数据科学以及数据科学的可解释性

2.6. 在不足和过度之间,每个人和企业都将自行决定所处的位置,这将受到社会和客户如何评价数据科学伦理的影响

- 2.6.1. 事实上,你既是客户又是社会的一员,所以你也在决定着对错之分,这进一步说明了伦理学的主观性

2.7. 数据科学本身就与歧视有关

-

2.7.1. 区别是否可能偿还贷款的申请借款人

-

2.7.2. 区别忠实客户和可能会流失的客户

-

2.7.3. 区别对我方产品感兴趣的人和对我方产品不感兴趣的人

2.8. 涉及公平时需要考虑三个关键因素:种族、性别或宗教

- 2.8.1. 事实并非只是如此,这还需取决于用途:比如在医学诊断中,种族和性别是重要的科研动机变量

2.9. 歧视在应用中的依赖性

-

2.9.1. 依赖性具有敏感性,因时间和地区的变化而变化

-

2.9.1.1. 男女平等最近才被社会普遍接受

2.9.1.1.1. 美国女性于1920年才普遍获得选举权

2.9.1.1.2. 美国西点军校直到1976年才首次招收女学员

2.9.1.1.3. 欧洲的妇女花了一个世纪的时间才首次拥有了投票权

2.9.1.1.4. 比利时女性在1948年获得了投票权

2.9.1.1.5. 摩尔多瓦也直到1978年才赋予女性投票权

-

2.9.1.2. 反对种族歧视并非一直被社会认可

2.9.1.2.1. 1870年美国宪法第十五条修正案才正式赋予黑人投票权

-

-

2.9.2. 现在我们大多认为这些是理所应当的权利,但将来我们也会被认为是时代的受害者

-

2.9.2.1. 第一个是我们认为可以歧视的人群,但是他们现在有多数人拥有的权利

2.9.2.1.1. 老年人和低收入人群

2.9.2.1.2. 也许未来我们会认为,把年龄和收入看作敏感因素令人无法接受

-

2.9.2.2. 第二个是我们现在认为不值得拥有我们所有权利的群体

2.9.2.2.1. 动物或机器人

-

-

2.9.3. 在看历史上和本书中的警世故事时,要保持温和的心态,因为这些故事往往是用我们新获得的伦理观点来阐述的

-

2.9.4. 区域因素也很重要,美国和欧洲法律的差别可以证明这一点

- 2.9.4.1. 不同国家对个人和国家权利的尊重程度也不同

2.10. 由于伦理具有主观性,每个公司都有责任决定在公司日常工作中进行何种数据科学伦理实践

3. 数据科学

3.1. 数据科学:研究并指导有原则地从数据中提取信息和知识的学科的统称

3.2. 数据:事实或信息,尤其是指用于查证或做决策时所检验、运用的事实或信息

- 3.2.1. 数据是构建所有数据科学的关键模块

3.3. 算法:在解决一个特定问题时需遵循的一组规则

-

3.3.1. 算法可以应用于这些数据,以此来建立特定的数据科学模型

-

3.3.2. 算法只不过是一套需遵循的规则或步骤,我们无法直接判断其是否合乎伦理道德(除非算法的开发者明确表明该算法涉及伦理层面)

3.4. 预测或人工智能模型:通过预测或人工智能算法从数据中学习的决策公式

- 3.4.1. 一个预测模型也可能会违背伦理,这种情况大多因为该预测模型建立在有伦理问题的数据基础之上

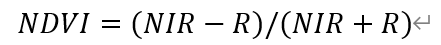

3.5. 数据挖掘:利用“数据科学”领域的技术从数据中提取知识和信息

-

3.5.1. 关于数据科学伦理的讨论大多以预测模型或监督学习为主,其中数据挖掘(或机器学习)技术用于发现数据中的模式,以预测模型的形式,预测一些目标变量的值

-

3.5.2. 描述建模或无监督学习也将从数据中提取模式,但这些模式并非(明确地)用于预测,而是用于探索数据中的描述模式

-

3.5.3. 聚类和关联规则挖掘是较为普遍的描述性数据挖掘

-

3.5.4. 计算机从数据中学习可解决特定问题的模式

3.6. 人工智能:随着时代的发展,根据智能代理的经验来提高其知识或性能的方法

-

3.6.1. 人工智能一直被归为智能代理领域,计算机试图模仿人类的学习和解决问题等认知功能

-

3.6.2. 典型的黑箱模型,无法解释做出某种预测的原因

-

3.6.3. 人工智能的某些领域已经超过了数据科学的范畴,比如通用人工智能和奇点

- 3.6.3.1. 与这些领域相关的特定伦理可能并不会与我们未来的日常生活有太多密切的关系

3.7. 技术没有好坏之分,但技术也不是中立的

- 3.7.1. 克兰兹伯格总结的“六大科技定律”中的第一条

3.8. 数据类型

-

3.8.1. 涉及个人隐私的个人数据

- 3.8.1.1. 个人数据:与已识别或者可识别的自然人(资料当事人)有关的任何信息

-

3.8.2. 涉及隐私的敏感数据

-

3.8.2.1. 此类数据同样也不应该用来歧视他人

-

3.8.2.2. 在医疗诊断等多数情况下,此类数据可能会有所帮助

-

3.8.2.3. 表明种族或民族起源、政治见解、宗教或哲学信仰或工会身份的数据

-

3.8.2.4. 为了识别某一自然人,而对其基因数据、生物数据进行处理

-

3.8.2.5. 与某一自然人的健康或性生活、性取向相关的数据,包含以上信息的个人数据不得泄露

-

-

3.8.3. 行为数据

-

3.8.3.1. 由于我们在环游世界的过程中,处处留下了“数字面包屑”,行为数据越来越成为一种有用的数据源

-

3.8.3.2. 个人行为的证据

-

4. 数据科学伦理平衡

4.1. 数据科学实践不能简单地被认定为合乎伦理还是违背伦理,它更多的是要平衡伦理考量和数据(科学)效用

-

4.1.1. 极端观点1:人们既不会对数据科学伦理投入丝毫的时间和精力,也不会对它感兴趣

-

4.1.2. 极端观点2:人们过于在乎数据科学伦理考量,所以不会使用任何数据

4.2. 伦理的重要性对个人而言具有主观性

4.3. 高风险系统包括用于就业、执法或移民等具有严格义务要求的系统

- 4.3.1. 有限风险(如聊天机器人)和最小风险(如垃圾邮件过滤器)

4.4. 如果一家公司不注重伦理思维、透明度,缺乏客户至上或引领行业的态度,那么此公司也不会重视数据科学伦理

4.5. 数据科学伦理平衡:受伦理考量和数据效用影响的一种数据科学实践的状态

4.6. 数据科学伦理实践

-

4.6.1. 限制用于公共用途的数据

-

4.6.2. 通过添加噪声或者概括性变量来移除信号

-

4.6.3. 改变标签

-

4.6.4. 消除对敏感群体的歧视

-

4.6.5. 进行更多评价分析

-

4.6.6. 并且将预测模型的空间限制在可理解的范围内等

4.7. 数据科学在银行业的成熟应用表明了数据科学效用的重要性

-

4.7.1. 预测模型通常不使用性别模型和传统的预测模型,并且伴有严格的保护隐私的政策

-

4.7.2. 也是对预测性维护(一种行业应用)方面的考虑,即数据科学会预测机器发生故障的时间,以便在故障发生前分派技术人员进行维护

- 4.7.2.1. 预测性维护使用的数据通常与机器相关,如机器的温度、振动、运行时间等

4.8. 如果不考虑伦理平衡就会产生一定风险,导致失衡

- 4.8.1. 不切实际的要求可能会导致人们拒绝使用任何数据的极端情况

4.9. 我们可能会在后来意识到这涉及伦理问题,但在当时并不容易察觉

来源链接:https://www.cnblogs.com/lying7/p/18855444

如有侵犯您的版权,请及时联系3500663466#qq.com(#换@),我们将第一时间删除本站数据。

暂无评论内容