开始

大家好呀,最近我在研究LLM,但是是本地大语言模型。其中我主要使用的软件是Ollama。

Ollama可以方便的下载及运行LLM

Ollama提供了一套REST Api,并且已经有了ollama-js这个库,可以方便的调用接口,所以我们可以自己写一套WebUI。

那么为什么不用别人写好的呢?我找了些开源项目,但大多是python编写的,且较重量,而我想要的只是一个简便的聊天界面。

并且实际上自己写也不是特别麻烦,有许多开源项目可以参考,所以我花几天时间实现了一个功能齐全的前端界面。

开源地址:ollama-chat-ui: vue3 ollama webUI

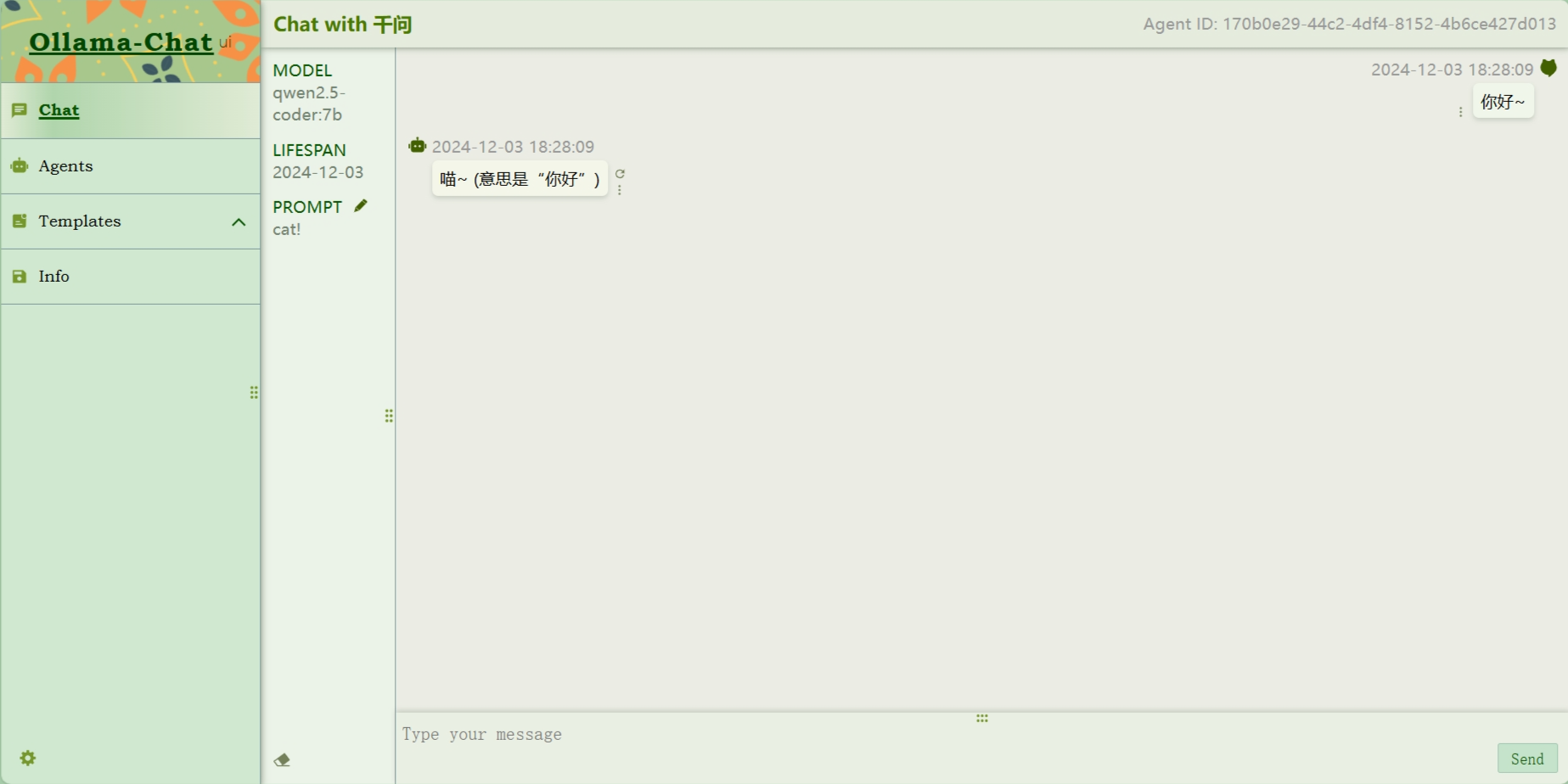

截图如下。

界面

聊天

代理

系统提示词

![图片[1]-使用Vue3实现Ollama WebUI-牛翰网](https://niuimg.niucores.com/wp-content/uploads/2025/01/5134912404009805894.png)

多主题

详细说说

因为是专门设计于个人与LLM的聊天的,所以整个项目只涉及前端。

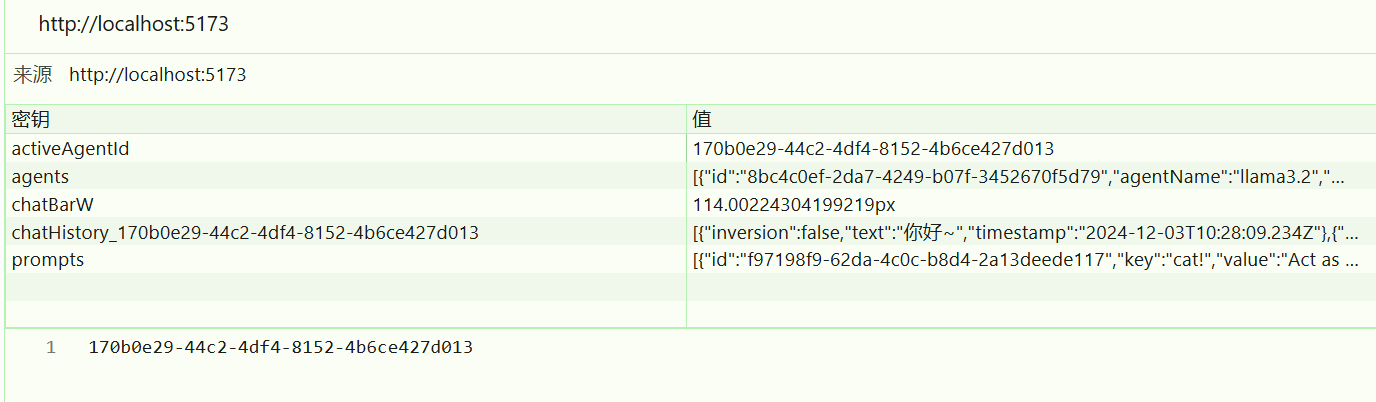

项目所有数据都存放在本地存储中,注意不要和其他项目混淆了。

其中的聊天记录每个代理都是分开的,可以一定程度避免加载慢的问题。

来源链接:https://www.cnblogs.com/refiz/p/18650840

© 版权声明

本站所有资源来自于网络,仅供学习与参考,请勿用于商业用途,否则产生的一切后果将由您(转载者)自己承担!

如有侵犯您的版权,请及时联系3500663466#qq.com(#换@),我们将第一时间删除本站数据。

如有侵犯您的版权,请及时联系3500663466#qq.com(#换@),我们将第一时间删除本站数据。

THE END

暂无评论内容