背景

大型语言模型(Large Language Models,简称LLMs)是一类先进的人工智能模型,它们通过深度学习技术,特别是神经网络,来理解和生成自然语言。这些模型在自然语言处理(NLP)领域中扮演着越来越重要的角色。以下是大型语言模型的一些关键特点和应用:

1. 定义和工作原理

- 定义:大型语言模型是基于大量数据训练的复杂神经网络,能够捕捉和模拟语言的复杂性和多样性。

- 工作原理:这些模型通常使用变换器(Transformer)架构,这是一种基于自注意力机制的模型,能够处理序列数据,如文本。自注意力机制允许模型在处理一个单词时考虑到整个文本序列中的其他单词,从而更好地理解上下文。

2. 关键特点

- 大规模数据训练:使用大量的文本数据进行训练,这些数据可能包括书籍、文章、网页等。

- 深度学习:利用深度神经网络来学习语言的复杂模式。

- 自注意力机制:允许模型在处理文本时考虑到单词之间的长距离依赖关系。

- 预训练和微调:通常先在大规模数据集上进行预训练,然后在特定任务上进行微调。

3. 应用领域

- 文本生成:自动生成文本,如文章、故事、对话等。

- 语言翻译:将一种语言的文本翻译成另一种语言。

- 文本摘要:生成文本的简短摘要。

- 情感分析:分析文本中的情感倾向。

- 问答系统:回答用户基于文本的问题。

- 文本分类:将文本分类到预定义的类别中,如垃圾邮件检测、新闻文章分类等。

4. 技术挑战

- 计算资源需求:训练大型语言模型需要大量的计算资源和能源。

- 数据偏见:训练数据中的偏见可能会被模型学习并反映在其输出中。

- 解释性:模型的决策过程往往是黑箱,难以解释和理解。

5. 社会影响

- 正面影响:提高自动化水平,增强信息处理能力,辅助决策。

- 负面影响:可能加剧信息不对称,误用可能导致误导或错误信息的传播。

大型语言模型是人工智能领域的一个重要分支,它们的发展和应用正在不断推动语言技术的进步,同时也带来了新的挑战和伦理问题。

大型语言模型(Large Language Models,简称LLMs)的介绍

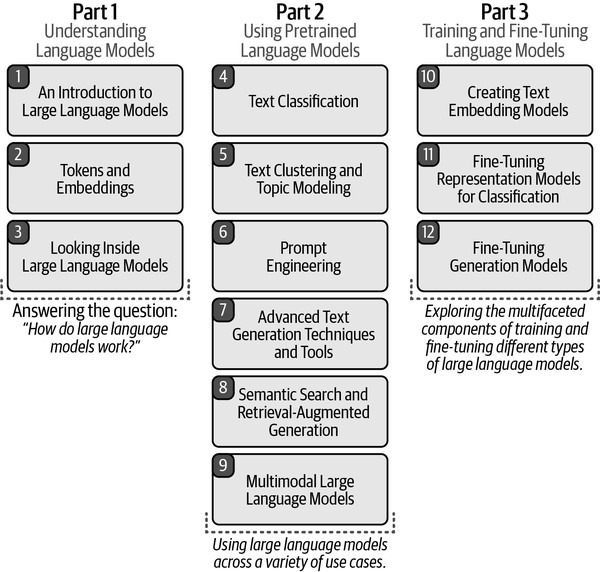

第一部分:理解语言模型

-

大型语言模型简介

- 介绍大型语言模型的基础知识。

-

Token和嵌入(Embeddings)

- 讨论语言模型中的Token概念和嵌入技术。

-

深入大型语言模型

- 解答“大型语言模型如何工作?”的问题。

第二部分:使用预训练语言模型

-

文本分类

- 利用预训练语言模型进行文本分类任务。

-

文本聚类和主题建模

- 介绍如何使用语言模型进行文本聚类和主题建模。

-

Prompt工程

- 探讨高级文本生成技术和工具。

-

语义搜索和检索增强生成

- 讨论如何结合语义搜索和检索增强生成技术。

-

多模态大型语言模型

- 探讨在多种用例中使用大型语言模型。

第三部分:训练和微调语言模型

-

创建文本嵌入模型

- 介绍如何创建用于文本嵌入的模型。

-

微调表示模型进行分类

- 探讨如何微调表示模型以进行文本分类。

-

微调生成模型

- 探索训练和微调不同类型大型语言模型的多方面组件。

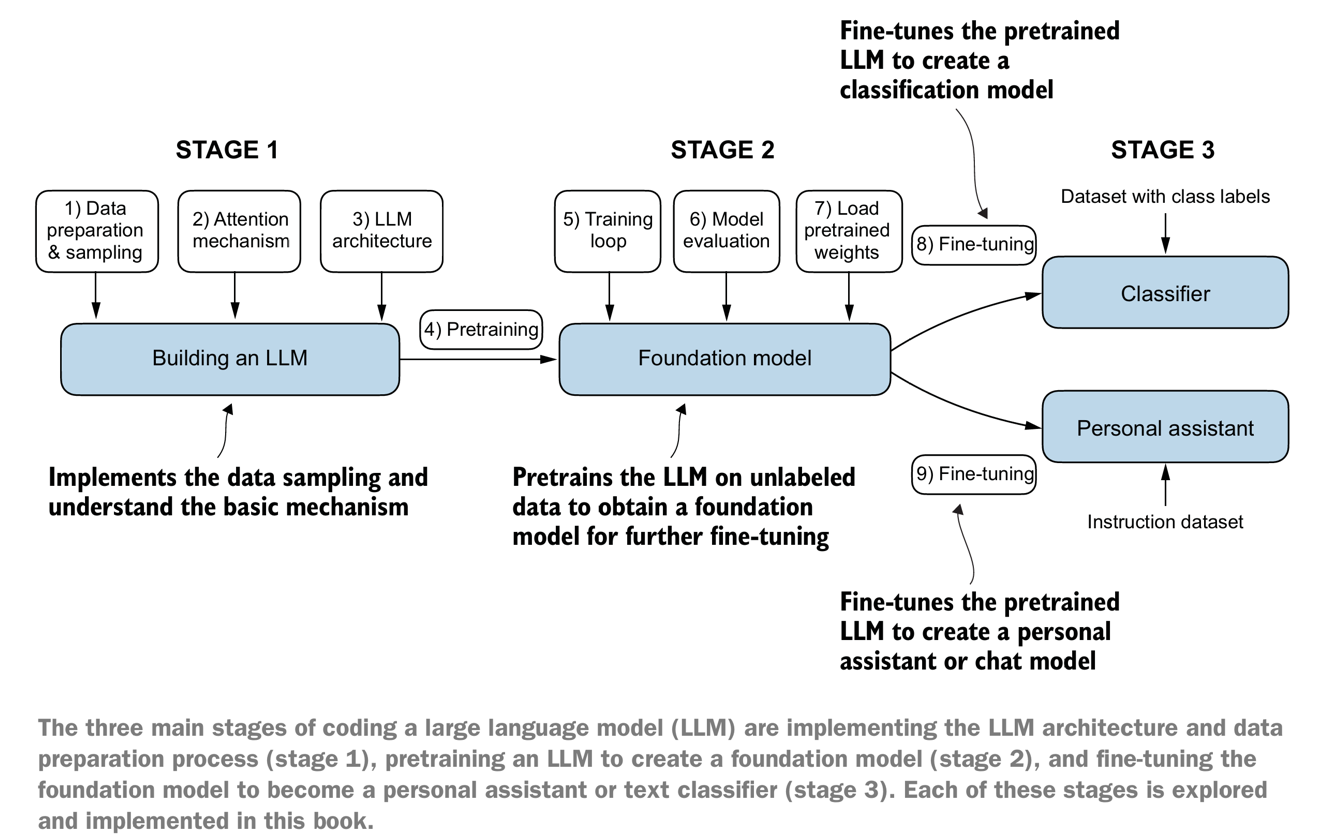

构建大型语言模型(LLM)的三个主要阶段

第一阶段:准备与采样

- 构建大型语言模型(LLM)

- 实施数据采样。

- 理解基本机制。

- 包括以下步骤:

- 数据:构建用于进一步微调的基础模型。

- 注意力机制:架构。

- LLM:语言模型。

- 预训练:数据,以获得基础模型。

第二阶段:预训练与评估

-

预训练基础模型

- 预训练LLM以创建一个基础模型。

- 包括以下步骤: 5. 训练循环:基础模型。 6. 模型评估:使用预训练的权重。 7. 加载:预训练的权重。

-

微调预训练的LLM

- 微调预训练的LLM以创建个人助手或聊天模型。

- 包括以下步骤: 8. 微调:使用指令数据集。 9. 微调:使用带类别标签的数据集创建分类器。

第三阶段:微调与分类

- 微调基础模型

- 微调基础模型以成为个人助手或文本分类器。

- 包括以下步骤:

- 微调后的模型可以用于创建个人助理或文本分类器。

包括从数据准备和模型架构的实现,到预训练以创建基础模型,再到微调基础模型以适应特定应用的过程。

数据采样

在构建大型语言模型(LLM)的过程中,数据采样是一个关键步骤,它涉及到从大量可用数据中选择代表性样本以训练模型。以下是一些常用的数据采样方法:

-

简单随机采样(Simple Random Sampling):

- 从数据集中随机选择样本,每个样本被选中的概率相等。

-

分层采样(Stratified Sampling):

- 首先将数据分成几个子集或层,然后从每一层中随机选择样本,以确保每个子集在样本中都有代表。

-

系统采样(Systematic Sampling):

- 选择一个随机起点,然后按照固定的间隔选择样本。这种方法适用于数据集可以被排序的情况。

-

分层随机采样(Stratified Random Sampling):

- 结合了分层采样和简单随机采样的特点,先进行分层,然后在每个层内进行随机采样。

-

聚类采样(Cluster Sampling):

- 将数据分成若干个群组,然后随机选择一些群组,并使用这些群组中的所有数据。

-

重要性采样(Importance Sampling):

- 根据数据点的重要性(通常是预先定义的概率分布)来选择样本,重要性高的样本更有可能被选中。

-

分层重要性采样(Stratified Importance Sampling):

- 结合了分层采样和重要性采样,先进行分层,然后在每一层内根据重要性进行采样。

-

自助采样(Bootstrap Sampling):

- 从数据集中随机选择样本,并允许样本被多次选中。这种方法通过有放回的抽样来生成新的数据集。

-

平衡采样(Balanced Sampling):

- 确保样本中不同类别的数据点数量大致相等,这对于处理不平衡数据集特别有用。

-

合成采样(Synthetic Sampling):

- 使用数据生成技术(如SMOTE)来创建合成样本,这在处理少数类样本不足时非常有用。

在实际应用中,选择哪种采样方法取决于数据的特性、模型的需求以及计算资源。有时,为了提高模型的泛化能力和性能,可能会结合使用多种采样技术。

Token和嵌入(Embeddings)

在大型语言模型(LLM)中,”Token”和”嵌入(Embeddings)”是两个核心概念,它们对于理解和处理自然语言至关重要。下面分别解释这两个概念:

Token

-

定义:

- Token 是自然语言处理中的一个基本单元,通常是单词、字符或子词(wordpiece)。

- 在文本处理中,原始文本首先被分割成一个个的Token,这些Token是模型处理和理解语言的基础。

-

作用:

- 标准化处理:将文本分割成Token有助于标准化输入,使得模型能够以统一的方式处理不同的文本。

- 词汇表构建:Token化是构建词汇表的第一步,词汇表是模型理解和生成语言的关键。

-

Token化方法:

- 基于空格的Token化:最简单的方法,按照空格和标点符号将文本分割成单词。

- 基于规则的Token化:根据特定的语言规则进行Token化,例如,处理连字符、缩写等。

- 子词Token化:如Byte Pair Encoding (BPE) 或 WordPiece,将单词进一步分割成更小的单元,以更好地处理罕见词和拼写错误。

嵌入(Embeddings)

-

定义:

- 嵌入 是一种将Token转换为固定长度的向量表示的技术。

- 这些向量捕捉了Token的语义和语法信息,使得模型能够理解和处理语言。

-

作用:

- 语义信息:嵌入向量能够捕捉单词的语义信息,使得语义相近的单词在向量空间中更接近。

- 计算效率:将单词转换为固定长度的向量,便于模型处理和计算。

-

嵌入类型:

- 词嵌入(Word Embeddings):最常见的类型,每个单词映射到一个向量。

- 字符嵌入(Character Embeddings):将字符作为基本单元进行嵌入,有助于处理拼写错误和罕见词。

- 上下文嵌入(Contextual Embeddings):如BERT模型中的嵌入,考虑单词的上下文信息,每个单词的嵌入向量可以根据不同上下文而变化。

-

训练方法:

- 预训练:在大规模语料库上预训练嵌入,如Word2Vec、GloVe等。

- 微调:在特定任务的数据集上进一步训练预训练的嵌入,以适应特定任务。

小结

Token 是文本处理的基本单元,而 嵌入 是将这些Token转换为模型可以理解的数值表示。

这两个概念是构建和训练大型语言模型的基础,对于模型的理解和生成能力至关重要。

通过Token化和嵌入,大型语言模型能够更有效地处理和理解自然语言,从而在各种自然语言处理任务中表现出色。

来自书籍

今天先到这儿,希望对云原生,技术领导力, 企业管理,系统架构设计与评估,团队管理, 项目管理, 产品管理,信息安全,团队建设 有参考作用 , 您可能感兴趣的文章:

构建创业公司突击小团队

国际化环境下系统架构演化

微服务架构设计

视频直播平台的系统架构演化

微服务与Docker介绍

Docker与CI持续集成/CD

互联网电商购物车架构演变案例

互联网业务场景下消息队列架构

互联网高效研发团队管理演进之一

消息系统架构设计演进

互联网电商搜索架构演化之一

企业信息化与软件工程的迷思

企业项目化管理介绍

软件项目成功之要素

人际沟通风格介绍一

精益IT组织与分享式领导

学习型组织与企业

企业创新文化与等级观念

组织目标与个人目标

初创公司人才招聘与管理

人才公司环境与企业文化

企业文化、团队文化与知识共享

高效能的团队建设

项目管理沟通计划

构建高效的研发与自动化运维

某大型电商云平台实践

互联网数据库架构设计思路

IT基础架构规划方案一(网络系统规划)

餐饮行业解决方案之客户分析流程

餐饮行业解决方案之采购战略制定与实施流程

餐饮行业解决方案之业务设计流程

供应链需求调研CheckList

企业应用之性能实时度量系统演变

如有想了解更多软件设计与架构, 系统IT,企业信息化, 团队管理 资讯,请关注我的微信订阅号:

作者:Petter Liu

出处:http://www.cnblogs.com/wintersun/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。 该文章也同时发布在我的独立博客中-Petter Liu Blog。

没有回复内容